Gen'ichi Taguchi, estadístico e ingeniero japonés, fue uno de los personajes más importantes en el desarrollo de técnicas estadísticas para la mejora de los procesos de manufactura. Taguchi fue el principal propulsor de lo que se conoce como Ingeniería Robusta, método que apunta a una reducción en la variabilidad de los outputs de los procesos. Históricamente, se buscaba reducir la variabilidad de los procesos a través de la eliminación de las fuentes de ruido que la producían, algo bastante utópico y complejo de realizar. El Método Taguchi, en cambio, se basa en eliminar o minimizar los efectos de los ruidos, y no los ruidos en sí.

La variabilidad de los procesos son provocados por parámetros que no pueden ser controlados. A estos parámetros se los conoce como ruidos de proceso. El Diseño de Experimentos (DOE, por las iniciales en inglés de Design of Experiments) es una disciplina que permite analizar qué efectos provocan los ruidos sobre los procesos de manera cuantitativa. Esta relación causa-efecto es modelada mediante una relación funcional, la cual se logra con ayuda experimental. La información obtenida empíricamente permite entender el 'peso' de cada fuente de ruido sobre la variabilidad del proceso. Muchos parámetros de ruido podrán tener efectos considerables, otros leves, y otros despreciables.

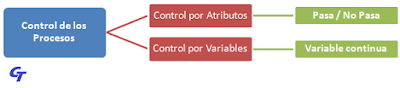

Taguchi fue también el creador del concepto de ingeniería de calidad, que contempla control de calidad en línea y fuera de línea (on-line y off-line). El control en línea contempla toda actividad de control y mantenimiento de procesos, apoyado generalmente por el uso de gráficas de control. El control fuera de línea es un concepto algo más innovador y se utiliza en la etapa de diseño de los productos y los procesos involucrados. La técnica utilizada en este caso es el DOE.

14 pasos para el Diseño de Experimientos

El DOE se basa en datos empíricos. Éstos pueden ser obtenidos si se siguen los siguientes pasos fundamentales:

- Se define el objetivo del análisis, en cuanto al alcance, los costos y el fin.

- Se conforma un equipo de trabajo para el proyecto de mejora mediante DOE.

- Se especifica concretamente el problema. Se puede utilizar alguna técnica de análisis de problemas, como los Diagramas de Ishikawa o Pareto, cuyos datos se pueden obtener de un brainstorming.

- Se evalúa el entorno técnico y humano.

- Se define y valida el sistema de medida.

- Se construye el DOE, mediante ensayos de factibilidad y procedimientos específicos de trabajo.

- Se preparan los ensayos.

- Se ejecutan los ensayos.

- Se miden los ensayos.

- Se analizan los resultados, discriminando señal de ruido, y se realiza el modelado.

- Se eligen los valores óptimos de los parámetros.

- Se realizan nuevas experiencias para confirmar.

- Se informan los resultados.

- Se comparan los progresos obtenidos con los objetivos planteados en los primeros puntos.

La Función de Pérdida de la Calidad de Taguchi

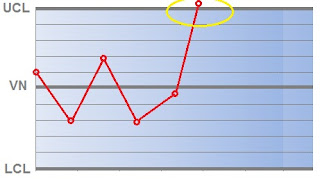

La Función de Pérdida de la Calidad de Taguchi permite calcular y cuantificar cuánto nos alejamos del valor esperado (objetivo) de un parámetro en particular. Esta valorización se realiza en unidades monetarias. Cuanto más alejado esté el parámetro del valor esperado (objetivo o target), mayor será la pérdida monetaria asociada que se transfiere al cliente.

|

| Función de Pérdida de Taguchi |

Este crecimiento es exponencial y está definido por la siguiente ecuación:

L(x) = k · (x - T)²

en donde L(x) es el resultado de la función de pérdida, x el valor de la característica analizada, T su valor esperado y k una constante de conversión a unidades monetarias. Por lo tanto, si L = 0, estamos ante la calidad esperada. A medida que L se aleja de 0, en cualquier sentido, vamos perdiendo calidad y aumentando los costos. Existen límites de tolerancia, en donde L toma un valor máximo permitido: el Límite Inferior de Especificación y el Límite Superior de Especificación. Se observa una diferencia con el enfoque tradicional de tolerancia, en el que se considera que dentro de los límites no hay pérdida alguna.